Google Watermarks Immagini generate dall’intelligenza artificiale – Voister

– L’intelligenza artificiale può sbloccare un enorme potenziale creativo, ma comporta anche nuovi rischi, come consentire ai creatori di diffondere informazioni false, intenzionalmente o meno. La capacità di identificare quando il contenuto viene generato dall’intelligenza artificiale è fondamentale per consentire alle persone di sapere quando si stanno integrando con i media generati e per prevenire la diffusione di disinformazione, ha scritto DeepMind in un post sul blog, secondo Techcrunch.

SynthID è stato sviluppato da Deepmind, la divisione AI di Google, ed è disponibile in versione beta per utenti selezionati di Vertex AI (la piattaforma di Google per la creazione di applicazioni e modelli di intelligenza artificiale).

SynthID utilizza due modelli di intelligenza artificiale, uno per la filigrana e uno per l’identificazione, che sono stati addestrati insieme su una varietà di immagini.

Non viene rilevato dagli esseri umani

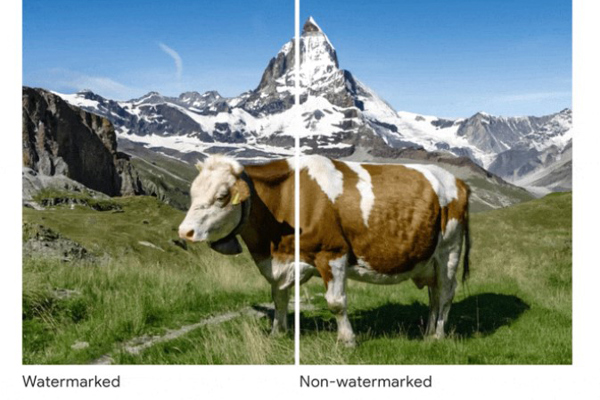

Lo strumento incorpora una filigrana digitale direttamente nei pixel dell’immagine, qualcosa che non può essere rilevato dall’occhio umano, ma invece da un algoritmo.

SynthID supporta solo Imagen, il modello text-to-image di Google. Lo strumento dovrebbe consentire di determinare facilmente se Imagen è stato utilizzato per creare un’immagine. A lungo termine, la tecnologia potrebbe diventare uno strumento contro i deepfake e altre disinformazioni.

– Non è garantito che SynthID sia sicuro contro una grave manipolazione delle immagini, ma offre un approccio tecnologico promettente per consentire a persone e organizzazioni di lavorare in modo responsabile con i contenuti generati dall’intelligenza artificiale. Lo strumento può anche essere sviluppato insieme ad altri modelli di intelligenza artificiale e in forme diverse dalle immagini, come audio, video e testo, ha scritto Deepmind.

“Evangelista della musica. Fanatico del cibo malvagio. Ninja del web. Fan professionista dei social media. Maniaco dei viaggi sottilmente affascinante.”